L’hypertrucage ou le deepfake est un procédé de manipulation d’un fichier audio, visuel ou vidéo qui recourt aux algorithmes de l’apprentissage profond pour créer des trucages ultraréalistes¹.

Technique développée en 2016 dans les milieux de la recherche, elle s’est rapidement fait connaitre du grand public lorsque des liens vers de fausses vidéos à caractère pornographique, censées mettre en scène des personnalités publiques, sont apparues sur la plateforme Reddit². Tout contenu numérique distribué en ligne peut être truqué. Vous l’aurez compris, l’hypertrucage est souvent effectué dans un but malveillant pour causer du tort à une personnalité publique. Les dangers associés aux hypertrucages vont au-delà des vidéos à caractère pornographique.

La vidéo ci-contre montrant deux bambins accourant pour s’enlacer a fait le tour des réseaux sociaux en envoyant un message positif de tolérance et d’amitié. Cependant, au cours de la campagne présidentielle américaine, elle a été manipulée de sorte que l’on voit l’un des bambins fuyant l’autre. La nouvelle vidéo s’intitule Terrified toddler runs from racist baby (Bambin apeuré fuit un enfant raciste) et a été partagée par le président Trump, véhiculant ainsi un message de peur et d’intolérance.

Vidéo originale publiée sur CNN montrant deux bambins qui sont visiblement amis.*

Vidéo truquée publiée sur CNN montrant l’un des bambins fuyant l’autre.*

En 2019, on dénombrait 15 000³ vidéos hypertruquées sur les réseaux sociaux, une augmentation de 83% en un an! Depuis, la tendance se maintient, stimulée par la quantité de logiciels deepfake accessibles au grand public.

L’hypertrucage peut inclure l’ajout, la modification ou la suppression d’objets dans une vidéo ou une image. Cette technique se prête particulièrement bien aux visages puisqu’ils partagent tous les mêmes attributs (yeux, nez, bouche, etc.). L’algorithme « apprend » d’abord l’apparence du visage original de plusieurs angles. À partir de là, il peut se produire deux choses : soit le visage est permuté sur une cible (face swap), souvent celle d’une personnalité publique ; soit le visage d’une personnalité est truqué de sorte que l’algorithme lui fait dire des choses qui ne lui correspondent pas.

Alors que cette technologie continue de se raffiner, certains craignent que l’on confonde de plus en plus les vraies vidéos et leurs versions trafiquées.

Ces images et vidéos contrefaites peuvent faire du mal tant à la société qu’aux individus. Elles peuvent être utilisées pour de la diffamation ou de l’extorsion.

– Mohamed Dahmane, chercheur en vision par ordinateur au CRIM

En 2017, le ministère de la Défense nationale du Canada lançait le programme Innovation pour la défense l’excellence et la sécurité (IDEeS), représentant un investissement de 1,6 milliard $ sur 20 ans. Ce programme propose des défis technologiques ouverts aux organismes de recherche et aux entreprises.

Les experts du CRIM se sont penchés sur le défi Vérification de l’intégrité de la vidéo pleine vitesse avec pour objectif de développer un prototype basé sur l’intelligence artificielle qui détecterait les contenus truqués en circulation sur Internet et qui différencierait les éléments vrais du faux pour une image donnée.

Le prototype détecteur de faux

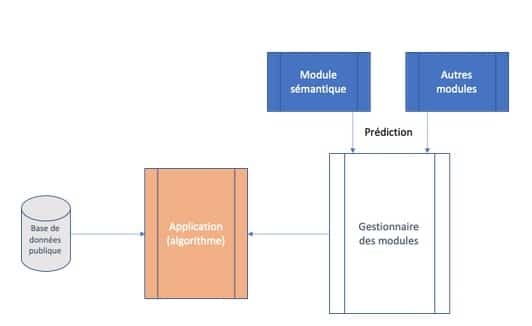

Le prototype et ses modules (plugins) ont été bâtis à partir d’un ensemble de 10 765 images truquées**. Le module sémantique développé par le chercheur Mohamed Dahmane classe les pixels de chaque image et détecte ceux qui sont manipulés.

Figure 1. Diagramme multi-modal de détection du CRIM

L’image ci-contre montre un avion (réel) auquel est ajouté un petit avion (fictif). Le but était de déterminer la capacité du module sémantique à détecter les pixels de l’objet fictif et à déduire qu’il s’agit d’un faux.

Figure 2. L’image originale à laquelle est ajouté un faux.

Comme illustré, le module sémantique a su détecter le contour (pixels) du petit avion avec un coefficient de communauté élevé de 77%***. En d’autres termes, il a repéré 77% des images que les experts avaient signalées manuellement.

Figure 3. Le module sémantique du CRIM détecte les pixels du petit avion.

Avec ce type de solution basée sur l’apprentissage profond (deep learning), il devient plus aisé de détecter le trucage d’images.

La lutte aux hypertrucages s’annonce néanmoins difficile, puisqu’à mesure que des solutions seront proposées, d’autres logiciels de trucage seront élaborés. « C’est le jeu du chat et de la souris », conclut Mohamed Dahmane.

Temps et efforts devront être investis dans l’amélioration du modèle de détection. C’est d’ailleurs avec le soutien du Conseil de recherches en sciences naturelles et en génie du Canada (CRSNG) que le CRIM poursuivra ses recherches, car la détection des trucages ne se limite pas au monde des médias. En effet, Mohamed Dahmane a pour ambition de voir un jour les algorithmes développés au CRIM servir à certifier l’authenticité des contenus numériques dans un contexte judiciaire. Un projet à suivre!